おじさん、具体的に三十路くらいになってくると3時間くらいのライブやイベントで集中力が持たないということが増えてきてるのでちゃんと対策した話。

まとめると、食事を十分に取って、スポーツのように取り組めという感じ。

こうなった。

会場に入るまでの食事

体を動かすにはまずはエネルギーが必要である。当たり前なんだけど忘れられがちな大事なこと。

叫ぶにも、飛び跳ねるにも、振りコピするにも、演者の一挙手一投足を双眼鏡で見るにも、集中力を維持しつつ継続的に動くのに必要なのはエネルギーである。そしてエネルギーを取れるのは食事である。

色々試してみたがただ大量に食べればいいというわけでもない感じで、ある程度細かく食事を取った方がよいっぽい。自分の中で調子良く動けたときは以下の食事のパターンだった。

- 朝食 9時くらい:いつも通り食べる

- 昼食 12時くらい:いつもの昼食の5~6割くらい食べる

- ライブ開演1時間前:いつもの昼食くらい食べる

一時間前というのはなんとなく決めた数値であったが、筋肉のことを調べていると、体を作る元であるタンパク質が食べ物から分解されて吸収され始めるのが1時間半後くらいとの話なので、ある程度は根拠のある数字っぽい。

会場に入ってからの食事

ライブ開演一時間前に食べたのならエネルギー十分じゃね?と思うが、これだけ食べていてもライブ後半になってくると割と失速してくるんだなこれが。

エネルギーが足りないとなると補給しなくてはいけない。補給するとなると食事を取らないといけないわけだが、イベントのルール上は飲食禁止であるので一般的なテイクアウトとかは選べないし、軽食にしてもあまりかさばるものも選べない。いろいろ試した結果、イベント中のエネルギー補給には下記の3つがよかった。

スポーツする際のエネルギーとして使われるやつである。粉末スティックタイプ。

一般的なオタクのライブ前というと、いわゆる魔剤を飲んだり、レギュレーション違反ではあるものの酒を飲んでいる輩なんかもいる。自己責任だと思うし好きにすればいいと思うが、カフェインは利尿作用でトイレに行きたくなるのがよくない。酒は言わずもがな。

魔剤の糖分+カフェインブースト、酒による酩酊は覚醒作用に近いので体を無理やり動かしているという感じだが、アミノ酸は体を動かすエネルギーにちゃんと使われるものだから自分の意志で体がちゃんと動いているという感じがするし、トイレが近くもならないのでいいことしかない。

同じくスポーツする際のエネルギーとして使われるやつである。ゼリー飲料タイプ。

期待する効果としてはアミノバイタルProと概ね同じだが、こちらはもう少し即効性のあるエネルギーも含まれるし、商品の立ち位置で言うともう少し頑張りたい時のエネルギー補給で飲むタイプっぽい。ゼリー飲料だから粉末に比べて飲みやすいというのもある。

空腹感を満たすためのもの。そのまま食べられるパウチタイプ。

名前の通りもち麦とあと雑穀などが入っていて、アルミパックで常温保存可能かつ開けたらすぐ食べられるおにぎりみたいなやつ。食べ物としておいしいかといわれるとまぁ普通という感じだが、栄養補給としてみると味は全然悪くない、というかおいしい。

重要なのは甘くないということ。コンビニで買える小腹を満たす系の物はだいたい甘いものが多い。甘いもので血糖値を上げてしまうとエネルギーとして使われることより辛さの方が先に来てしまうので甘くないということはかなり重要。

上記のアミノバイタル2つで体を動かすエネルギーがあっても、空腹感があると案外元気よく動けないものである。そこを補うのがこのもち麦満足バーである。

補給タイミング

上記を用意して、エネルギー切れを感じた、または空腹感を感じた時に食べたらいいかというと違う。答えはまだエネルギーが切れていない、満腹感が残っているうちから食べるが正解である。

アミノ酸は摂取してから30分くらいで吸収されてエネルギーとして使われ始めるので、まずはアミノバイタルProを会場に入って席に着いたくらいで飲む。ライブが始まったら曲の合間の入れ替わりの時にアミノバイタル マルチエネルギーを1口とか2口くらい飲んでいく。幕感のアニメやMCがあるときにもち麦満腹バーを食べる。想像以上に激しい曲が続いたなと思ったらここでアミノバイタルProを足してもいい。状況によって決める。

大事なのは疲れてないうちから食べるor飲むこと。そうすると終演までエネルギーが持つし、えっもう終わり?もう二時間くらいいけるけど??くらいの体力感を残してライブを終えることができる。こんなに体が軽かったのはマジでひさしぶり。

着るもの履くもの

エネルギー補給が出来ればイベントでやりたいこととしては十分であるが、ここまで聞くと「あれ?これスポーツじゃんね?」って気が付けると思う。なのでここから先はやらなくてもいいけれどより快適に楽しめるようになるためスポーツの知識を借りてくるやつ。

ランニングシューズ

普通のシューズでもよいが、ランニングシューズはランニング以前にウォーキングにも向いている靴である。ライブに向いていないはずがない。

余談として、自分はバイクでライブ会場に向かう都合上ライディングシューズで行くことが多かったが、ランニングシューズの足への負担の軽さを知って、もしかしてライブ中にものすごく足の裏が痛くなるのはライディングシューズのせいじゃないか?とこの前気が付いた。なのでバイクで行ってもランニングシューズに履き替えるようにしてみたら足の裏が痛くなることはなくなった。やっぱりライディングシューズはバイク用の靴だったんや。

ランニングシューズはABCマートで1万円くらいで買えるものでもよいが、できれば予算2万円くらいでスポーツ専門店に行って足のサイズを計測して買ってくるのをお勧めする。圧倒的フィット感と足がめっちゃ軽くなって感動するし、ライブで飛び跳ねる時の跳躍力の追加にもなるのでよい。

自分はゼビオに行って店員さんに相談して、2つおすすめされたうちの気に入った方であったadidasのSUPERNOVA RISEを買った。

速乾インナー

運動みたいな激しい動きをするのであれば汗もかく。でもライブTは綿なので乾きにくく、濡れたシャツはライブ後冷えてよくないのでインナーを着た方が楽。

ライブをスポーツと捉えるのであればいわゆるコンプレッションウェアを買ってもいいのかもしれないが、ガチでスポーツやってるならともかくとして、個人的にはユニクロのEXドライの長袖で十二分だと思う。

ライブT着れないじゃんとなるかもしれないが、これを着た上にライブTを着ても全然OK。最近は真夏も日差しがきつすぎて長袖着ることが多くなったので年中これで大丈夫だと思う。

実績

2024/03/09~10のユニット甲子園に参加。

ライブ中は快適に飛び跳ねられたし、ライブ後もそんなに疲労感は無く、普段だったらフル高速で帰宅するところ若干下道を走りたいと思える程度には余裕があった。

翌日も目覚めはすっきり、起きるのがしんどいということはない。シンプルに昨日動いた分の肉体疲労が残っている感じはあったがしんどくて動けないという感じではなく、おいしい食事やゆっくり風呂に入って回復可能なレベルの疲労だった。

まとめ

一周回ってすげぇ健康的になってんな??

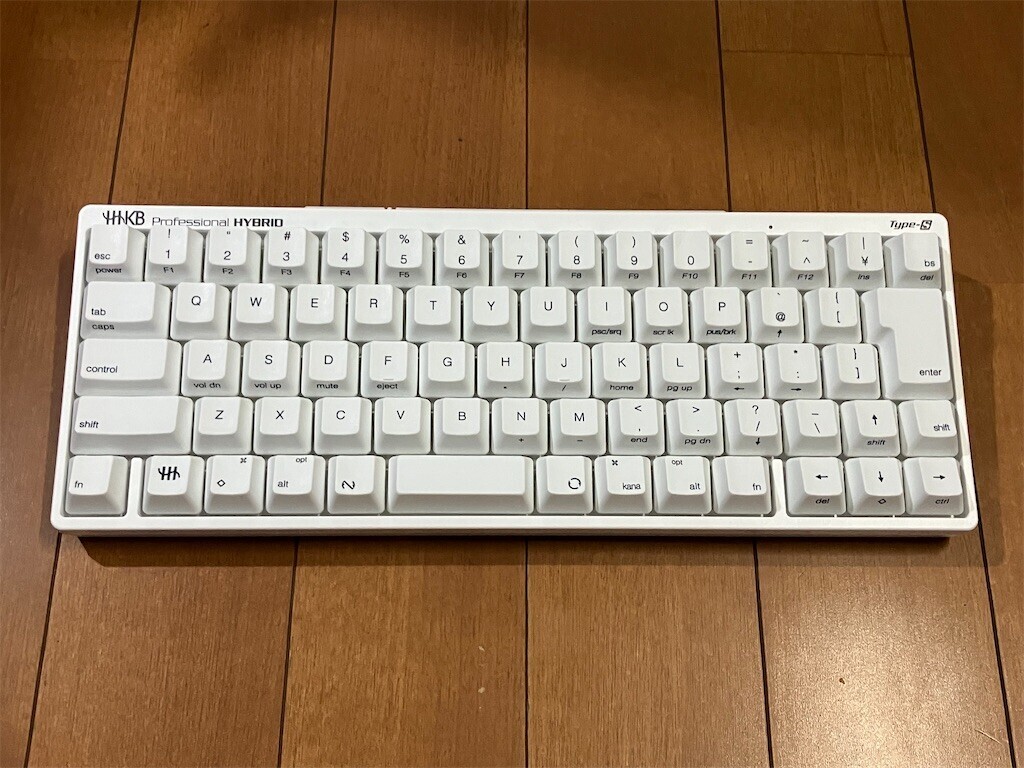

買ったのは「HHKB Professional HYBRID Type-S 日本語配列/雪」。

買ったのは「HHKB Professional HYBRID Type-S 日本語配列/雪」。